ComfyUI日盛,本文将一步步详细说明ComfyUI安装,包括A卡和N卡不同安装方法(两种显卡实测均无问题)。

# 本机电脑配置

电脑配置如下:

显卡:AMD RX580

CPU: I7 8086K

内存: 32GB非本机配置可供参考,整个安装流程适于A卡及N卡用户(均实测)。

A卡和N卡安装区别在本文安装步骤的第五步,请仔细阅读!

# 安装步骤

第一步 确定安装目录

在安装盘(建议SSD硬盘)建立目录(本例为C:\Users\wsanbai\AI)

第二步 下载ComfyUI

打开命令提示符,进入上一步所建目录,输入以下命令下载ComfyUI

git clone https://gitcode.com/gh_mirrors/co/ComfyUI.git以上版本为国内镜像(方便不能访问Github的朋友),非最新版本,如要使用最新版本请使用以下命令下载:

git clone https://github.com/comfyanonymous/ComfyUI.git也可先用国内镜像安装,然后打开ComfyUI\.git\config文件,将“url=”后面的网址改为“https://github.com/comfyanonymous/ComfyUI.git”,然后升级ComfyUI即可。

![图片[1]-一步步手把手,本机实操安装ComfyUI实现AI生图-红影堂](https://ilut.cn/wp-content/uploads/2024/10/20241024102237647-comfyui安装.jpg)

如没有git工具,请点击 GIT下载 安装!

命令输出如下,表示成功:

C:\Users\wsanbai\AI>git clone https://gitcode.com/gh_mirrors/co/ComfyUI.git

Cloning into 'ComfyUI'...

remote: Enumerating objects: 12639, done.

remote: Counting objects: 100% (4248/4248), done.

remote: Compressing objects: 100% (518/518), done.

remote: Total 12639 (delta 4100), reused 3730 (delta 3730), pack-reused 8391 (from 1)

Receiving objects: 100% (12639/12639), 5.94 MiB | 1.12 MiB/s, done.

Resolving deltas: 100% (8542/8542), done.第三步 安装python

由于ComfyUI不少扩展不支持python3.13,建议安装python3.10~3.12。

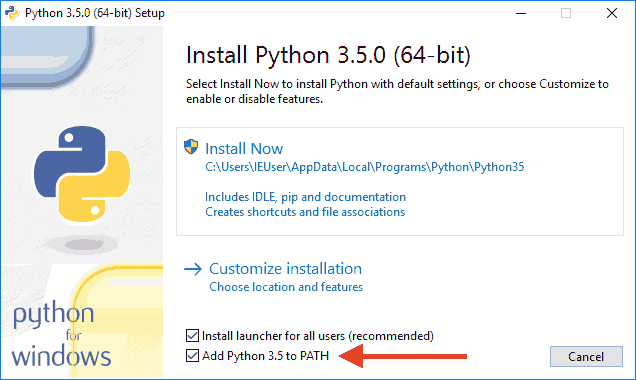

首先到Python官网下载Python,下载完成后运行下载的exe安装程序。

安装时特别要注意勾上Add Python 3.x to PATH,然后点“Install Now”即可完成安装!

如Python官网下载较慢,可在以下文章内下载:

安装完成后,转至命令行,输入以下命令:

python --version如显示如下,则表示Python安装成功:

C:\Users\wsanbai\AI>python --version

Python 3.10.6第四步 创建虚拟环境。

给ComfyUI创建一个虚拟环境,以方便管理,这样即便是把ComfyUI装在移动硬盘,也可在更换电脑的情况下轻松使用。

在命令提示符里输入以下命令:

cd comfyui #转到comfyui目录

python -m venv venv #创建虚拟环境这样,将在ComfyUI目录下建立一个venv文件夹,可自行查看文件夹是否创建成功。

然后在命令提示符输入以下命令,激活刚才创建的虚拟环境:

venv\Scripts\activate.bat以上命令需在ComfyUI文件夹下执行!

注意,以后在启动ComfyUI前,都需要先使用此命令激活当前ComfyUI的虚拟环境

激活成功后,将在命令行前会显示(venv)字样,如下所示:

(venv) C:\Users\wsanbai\AI\ComfyUI>第五步 安装ComfyUI依赖

在安装前更换pip为国内源,否则下载太慢(任选一个镜像源粘帖到命令行执行):

#清华源

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

# 阿里源

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple/

# 腾讯源

pip config set global.index-url http://mirrors.cloud.tencent.com/pypi/simple

# 豆瓣源

pip config set global.index-url http://pypi.douban.com/simple/

# 中国科学技术大学

pip config set global.index-url https://pypi.mirrors.ustc.edu.cn/simple换源完成后,首先来安装Torch,根据不同显卡安装不同版本。

# N卡安装Torch

我们的CUDA版本务必与Pytorch版本对应,先使用以下命令查看cuda版本:

nvcc --version输出示例:

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2024 NVIDIA Corporation

Built on Tue_Feb_27_16:28:36_Pacific_Standard_Time_2024

Cuda compilation tools, release 12.4, V12.4.99

Build cuda_12.4.r12.4/compiler.33961263_0由上可得知Cuda版本为12.4(如果输出错误则表示CUDA并未安装),然后打开Pytorch官网:

https://pytorch.org/get-started/locally/在打开的页面内会看到以下内容:

![图片[2]-一步步手把手,本机实操安装ComfyUI实现AI生图-红影堂](https://ilut.cn/wp-content/uploads/2024/10/20241022215907122-pytorch.jpg)

如上图所示,选择与自己显卡对应的CUDA版本(上图箭头所示),然后复制上图下方的命令(Run this Command),粘贴到命令提示符安装。

如果上图中没有和你对应的CUDA版本,则需要安装显卡相应的CUDA版本。因为CUDA版本一旦对不上,是不能实现显卡加速的。

这里提供CUDA12.4官网下载地址,需要其它版本自行查找下载:

https://developer.nvidia.com/cuda-12-4-0-download-archive确认版本没问题就基本不会出问题,但torch官网命令安装可能会很慢,我已把CUDA12.4对应的torch转存网盘:

下载完成后解压得到WHL后缀文件,然后使用以下命令安装:

pip install 解压的whl文件路径但torchvision和torchaudio(可不装)还是要使用官网命令安装(删除掉命令中第一个torch,因为已经安装完成)。

N卡在本步骤中就是Torch与CUDA版本对应,否则因为没有CUDA加速而无法启动ComfyUI

这些依赖包的安装一样需要时间,不过等它们安装完成,我们的ComfyUI也就要安装完成了。

# 启动ComfyUI

通用启动命令如下:

python main.py但启动命令有很多参数,各自可根据自己情况选用这些参数。比如我使用以下命令启动:

python main.py --directml --lowvram --use-split-cross-attention --dont-upcast-attention --force-fp16- –directml。因为我安装的directml,所以使用此参数。

- –lowvram。低内存模式,毕竟RX580显卡才8G。

- 后面几个是生图优化参数。

启动成功,命令行显示如下:

(venv) C:\Users\wsanbai\AI\ComfyUI>python main.py --directml --lowvram --use-split-cross-attention --dont-upcast-attention --force-fp16

Using directml with device:

Total VRAM 1024 MB, total RAM 32521 MB

pytorch version: 2.4.1+cpu

Forcing FP16.

Set vram state to: LOW_VRAM

Device: privateuseone

Using split optimization for cross attention

****** User settings have been changed to be stored on the server instead of browser storage. ******

****** For multi-user setups add the --multi-user CLI argument to enable multiple user profiles. ******

[Prompt Server] web root: C:\Users\wsanbai\AI\ComfyUI\web

C:\Users\wsanbai\AI\ComfyUI\venv\lib\site-packages\kornia\feature\lightglue.py:44: FutureWarning: `torch.cuda.amp.custom_fwd(args...)` is deprecated. Please use `torch.amp.custom_fwd(args..., device_type='cuda')` instead.

@torch.cuda.amp.custom_fwd(cast_inputs=torch.float32)

Import times for custom nodes:

0.0 seconds: C:\Users\wsanbai\AI\ComfyUI\custom_nodes\websocket_image_save.py

Starting server

To see the GUI go to: http://127.0.0.1:8188在浏览器输入 http://127.0.0.1:8188 网址,成功打开ComfyUI界面。

# 生图测试

我这里将一个XL模型放在以下文件夹内:

C:\Users\wsanbai\AI\ComfyUI\models\checkpoints正向提示词:

underground ancient city, glowing mushrooms, breathtaking, vibrant, magic, fantasy反向提示词:

(octane render, render, drawing, anime, bad photo, bad photography:1.3), (worst quality, low quality, blurry:1.2), (bad teeth, deformed teeth, deformed lips), (bad anatomy, bad proportions:1.1), (deformed iris, deformed pupils), (deformed eyes, bad eyes), (deformed face, ugly face, bad face), (deformed hands, bad hands, fused fingers), morbid, mutilated, mutation, disfigured采样器: dpmpp_sde_karras

尺寸:768X1024

![图片[3]-一步步手把手,本机实操安装ComfyUI实现AI生图-红影堂](https://ilut.cn/wp-content/uploads/2024/10/20241022152526921-a.jpg)

生图过程控制台信息如下:

got prompt

Requested to load SDXL

Loading 1 new model

loading in lowvram mode 64.0

100%|████████████████████████████████████████████████████████████████████████████████████| 6/6 [01:06<00:00, 11.13s/it]

Requested to load AutoencoderKL

Loading 1 new model

loading in lowvram mode 64.0

Prompt executed in 70.89 seconds# 总结

几百块的老显卡,SD15能玩,XL也能玩,FLUX还不知道能不能玩。一张768X1024图片生成时间在一分钟多点,最慢的采样器dpmpp_sde在11秒每步左右,其它采样器要快不少。

如果觉得启动ComfyUI输入命令太麻烦,可以自行建一个bat批处理文件,快速开启ComfyUI。

下面提供ComfyUI中文界面及扩展管理插件下载,下载完成解压后将其放于ComfyUI文件夹下的custom_nodes内:

# 快速启动

@echo off

cd C:\Users\wsanbai\AI\ComfyUI\

call venv\Scripts\activate.bat

python main.py --directml --lowvram --use-split-cross-attention

pause打开记事本,将上面代码复制进去,把路径修改成你的ComfyUI文件夹,N卡的话把 –directml 删除(启动参数自行测试修改),另存为comfyui.bat文件,把文件放于桌面以便快速启动。